BUSINESS INTELLIGENCE / BI PLATFORM ARCHITECTURE / DATA ANALYSIS / BUSINESS INTELLIGENCE APPLICATIONS / DECISION MAKING / BI PLATFORM MARKET / BUSINESS INTELLIGENCE SYSTEMS / BI PLATFORM COMPARISON / АРХИТЕКТУРА BI-ПЛАТФОРМ / АНАЛИЗ ДАННЫХ / ПРИЛОЖЕНИЯ БИЗНЕС-АНАЛИЗА / ПРИНЯТИЕ РЕШЕНИЙ / РЫНОК BI-ПЛАТФОРМ / СИСТЕМЫ БИЗНЕС-АНАЛИЗА / СРАВНЕНИЕ BI-ПЛАТФОРМ

Аннотация научной статьи по компьютерным и информационным наукам, автор научной работы — Седойкина Алина Алексеевна

Статья посвящена обзору наиболее популярных систем класса Business Intelligence , представленных на рынке инструментов и средств аналитической обработки данных. Рассматривается область бизнес-аналитики (бизнес-анализа) и ее направления, в том числе современные тенденции развития, средства и методы, а также проводится анализ, описание и сравнение наиболее популярных BI-платформ. Определены достоинства и недостатки BI-платформ.

i Надоели баннеры? Вы всегда можете отключить рекламу.

Похожие темы научных работ по компьютерным и информационным наукам , автор научной работы — Седойкина Алина Алексеевна

Обзор BI-платформ для применения в проектах информатизации здравоохранения

Разработка методики автоматизации комплексного бизнес-анализа для организаций МСБ на базе MS Power Bi

Трансформация оперативной отчетности компании на основе подхода Business Intelligence

Критериальное сравнение платформ бизнес-аналитики

Использование инструментов геоаналитики для подготовки бакалавров и магистров по направлению «бизнес-информатика»

i Не можете найти то, что вам нужно? Попробуйте сервис подбора литературы.

i Надоели баннеры? Вы всегда можете отключить рекламу.

ANALYTICAL DATA PROCESSING. OVERVIEW OF BI-PLATFORMS

This article reviews the most popular systems of the Business Intelligence class, presented on the market of tools for analytical data processing. The field of business analytics (business analysis) and its areas, including modern development trends, tools and methods, is analyzed, as well as the analysis, description and comparison of the most popular BI platforms. Advantages and disadvantages of BI platforms are identified.

Текст научной работы на тему «Аналитическая обработка данных. Обзор BI-платформ»

Седойкина Алина Алексеевна, магистрант, ФГБОУ ВО «Национальный исследовательский Мордовский государственный

университет им. Н.П. Огарева»

АНАЛИТИЧЕСКАЯ ОБРАБОТКА ДАННЫХ. ОБЗОР BI-ПЛАТФОРМ

Аннотация. Статья посвящена обзору наиболее популярных систем класса Business Intelligence, представленных на рынке инструментов и средств аналитической обработки данных. Рассматривается область бизнес-аналитики (бизнес-анализа) и ее направления, в том числе современные тенденции развития, средства и методы, а также проводится анализ, описание и сравнение наиболее популярных BI-платформ. Определены достоинства и недостатки BI-платформ.

Ключевые слова: business intelligence, архитектура BI-платформ, анализ данных, приложения бизнес-анализа, принятие решений, рынок BI-платформ, системы бизнес-анализа, сравнение BI-платформ.

Sedoikina Alina A., master degree student National Research Mordovia State University, Saransk

ANALYTICAL DATA PROCESSING. OVERVIEW OF BI-PLATFORMS

Abstract. This article reviews the most popular systems of the Business Intelligence class, presented on the market of tools for analytical data processing. The field of business analytics (business analysis) and its areas, including modern development trends, tools and methods, is analyzed, as well as the analysis, description and comparison of the most popular BI platforms. Advantages and disadvantages of BI platforms are identified.

Keywords: business intelligence, BI platform architecture, data analysis, business intelligence applications, decision making, BI platform market, business intelligence systems, BI platform comparison.

В настоящее время успешность предприятия на рынке зависит в большей степени от возможности менеджеров быстро реагировать на динамику рынка. Информация, необходимая для принятия оперативных решений в современной экономической среде становится стратегическим ресурсом фирмы. А знания занимают все больший удельный вес в структуре стоимости товаров и услуг, поэтому владеть просто информацией недостаточно. Необходимо, чтобы она была предварительно обработана и организована в целях быстрого анализа и принятия решений.

Наибольшую пользу управление знаниями способно принести в планировании, обслуживании клиентов, обучении персонала и сотрудничестве в рамках проектов. Одна из центральных идей управления знаниями — использовать более эффективно уже существующее знание.

Системы Business Intelligence — тот класс систем, которые предоставляют возможность преобразовать данные КИС и данные внешних источников в читаемые для менеджеров знания и информацию, необходимые для принятия решений. По общепризнанному определению, Business Intelligence (BI) — это совокупность компьютерных методов и инструментов, обеспечивающих перевод необработанной информации в осмысленную, удобную форму [1].

Сегодня, средства BI весьма разнообразны. Но можно выделить четыре основные направления систем бизнес-анализа (рис. 1).

Рисунок 1 — Направления развития В1-систем.

В1-платформа должна предоставлять пользователям и разработчикам набор специализированных инструментов для создания приложений бизнес-анализа. Все

Представлен Хранение ие данных данных

Анализ Интеграция данных данных

инструменты платформы для бизнес-анализа должны применять общие данные, сквозную модель администрирования, единую объектную модель и общий движок исполнения запросов [6].

Тенденцией среди разработчиков в последние три года стало построение собственных BI-платформ, фундаментом которых является технология Data Discovery (DD). Цель данной технологии — создать инструменты и средства, ориентированные на людей, поддерживающих их работу. Технология DD предоставляет возможность использовать интуицию человека при выделении значимой и полезной информации. Отличие от традиционного бизнес-анализа заключается в том, что представление обработанной информации наиболее наглядно и более высокое по скоростным характеристикам. Цикл технологии представлен на рис. 2.

В связи с развитием мобильных технологий появилась тенденция просмотра данных аналитики в любое время и в любом месте именно с мобильных устройств. Наиболее авторитетные разработчики платформ бизнес-аналитики своевременно отреагировали, выпустив дополнения к BI — приложения для мобильных телефонов и планшетов.

Сейчас на рынке представлено более 20 BI-платформ, и основываясь на уже проведенных исследованиях специалистов в данной области, отзывов аналитиков и авторитетных консалтинговых агентств, проведем обзор наиболее популярных инструментов.

На сегодняшний день первое место на рынке BI-платформ делят компании QlikView и Tableau. В платформе QlikView используется ассоциативный поиск в

Рисунок 2 — Цикл технологии Data Discovery.

оперативной памяти со встроенными средствами ETL (extraction, transformation, loading) [4]. В этом решение уникально, и неудачные попытки конкурентов воссоздать множественные функции QlikView, как правило, заканчиваются неудачей.

Ассоциативная архитектура позволяет поддерживать такие характеристики запросов как гибкость, производительность и ассоциативность на высоком уровне. Что нельзя сказать о традиционной архитектуре, где принятие решений происходит на основе интуитивных связей данных, ухудшая при этом их качество. Место OLAP-куба в BI-платформе QlikView занимает собственный инструмент — Business Discovery.

В целом инструмент имеет модульную архитектуру и состоит из следующих компонент (рис. 3).

Рисунок 3 — Модули платформы QlikView.

К преимуществам BI-платформы можно отнести интерактивную визуализацию, возможность одновременно использовать данные различных типов, проработанные дашборды, геопространственная аналитика и удобная совместная работа пользователей. Следуя современным тенденциям, QlikView представлена на мобильных платформах любого типа. Производительность весьма высокая, но могут возникать замедления при работе с большими объемами данных.

Ещё один лидер BI-решений — Tableau, в основе которого лежат собственные технологии VizQL (интерактивная визуализация данных) и Data Engine (анализ данных). Как и во многих BI-платформах имеется возможность использования данных из различных источников [5]. Ключевая особенность Tableau так

называемое «смешивание данных» — комбинирование данных из различных баз данных и иных источников. Также инструмент предоставляет возможность многопользовательского режима работы над отчетом, формируемом в специальном модуле Desktop. Подобно QlikView реализованы различные способы рассылки отчетов (электронная почта, доступ по ссылке, публикация на сервере Tableau). Tableau-решение из всех представленных на BI-рынке инструментов больше остальных преуспели в упрощении механизма доступа пользователей к анализу данных. Tableau обладает отличной функциональностью, включая периодические обновления карт и дополнительную информацию для целей геопространственной аналитики.

Уникальность следующей BI-платформы состоит в том, что она на 100% находится в облаке, что предоставляет возможность наиболее эффективной обработки данных, и возможность визуализировать данные с изменениями в realtime. Разработка канадской компании Klipfolio Dashboard отличается своей простотой и дружественным интерфейсом. Подобно вышеописанным конкурентам поддерживает данные различных типов как из online источников, так и offline.

К особенностям Klipfolio можно отнести совместимость с различными устройствами (смартфоны, планшеты, Smart TV и др.), многопользовательский режим и аутентификацию.

Онлайн-сервис от Microsoft Power BI также предоставляет возможность подключения данных разных источников. В платформе реализован web-интерфейс, с помощью которого можно создать кастомизированные визуализации, а проводить стандартизацию и очистку данных можно при помощи настольного приложения [3]. BI-платформа, не отличаясь от своих конкурентов, также идет в ногу со временем — реализована мобильная версия Power BI, доступная на различных операционных системах. Нельзя не отметить мощность и стабильность работы, а также то, что это в первую очередь, продукт Microsoft, что означает следование принципам и архитектуре одной из самых распространенных компаний. К ключевым характеристикам можно отнести бесплатную базовую версию,

различные способы импорта данных, изменение данных в реальном времени, рассылка отчетов несколькими способами.

Кратко охарактеризовав самые популярные BI-платформы, результаты обзора представим в виде таблицы для наглядности (таблица 1.).

Таблица 1 — Сравнительная таблица BI-платформ.

Критерий сравнения QlikView Tableau КНрГоИо Power BI

Особенности Ассоциативная модель данных. Широкие возможности визуализации, дополнительные фильтры, понятная интерактивность данных. Мониторинг и контроль в реальном времени непрерывных потоков данных. Поколоночное сжатие данных и вычисления в оперативной памяти.

Ключевые характеристики 1 .Большое количество полезных функций, для создания продвинутых дашбордов. 2.Хранение данных в ОП сервера. Широкие возможности для отправки отчетов и дашборды, поддержка данных из различных источников, интеграция этих данных. Аутентификация, неограниченное количество подключенных пользователй, мобильная версия, возможность добавлять аннотации к отчетам. Преобразование и очистка данных, создание модели; возможность создания визуальных элементов; создание и публикация отчетов.

Удобство использования В дашбордах и отчетах легко разобраться, но их весьма тяжело создавать. Дружественный интерфейс, самые широкие возможности среди BI-платформ. Возможность представить информацию в различном виде, но нужно подготовить данные. Удобный инструмент с использованием естественного языка.

Цена Одна из самых дорогих платформ. Запутанная ценовая политика Облачная платформа бесплатна, с условием хранения решений на сервере. Цена за пользователя 999$ в год. 2-х недельный пробный период, цена за пользователя 19$ в месяц. Несколько видов лицензирования, включая бесплатные.

Минимальная цена подписки 624,40 руб. за пользователя в месяц.

Таким образом, можно сделать вывод, что при использовании QlikView стоит обратить внимание на то, что пользователю, не владеющему технической базой будет достаточно сложно. Синтаксис не очевиден, выражения выглядят весьма необычно. Большие сложности с отправкой отчетов и с использованием платформы как рабочего инструмента для всей компании.

При использовании Klipfolio придется довольно долго обучаться базовым и сложным операциям. Нельзя не отметить отсутствие функций для предиктивной аналитики и прогнозирования. Также взимается дополнительная плата за CSS стили.

В Tableau есть необходимость предварительной обработки данных. Также в платформе отсутствует история изменений; и функции/опции могут показаться слишком узконаправленными и ограничивающими.

Power BI обладает ограниченным набором инструментов для обработки и очистки данных. Довольно часто возникают сложности с импортом и обработкой большого количества данных: программа зависает, либо вылетает.

1. Business Intelligence [Электронный ресурс] / URL: https://ru.wikipedia.org/wiki/Business_Intelligence.

2. Data Mining [Электронный ресурс] / URL: https: //ru.wikipedia. org/wiki/Data_mining.

3. Microsoft Power BI [Электронный ресурс] / URL: https://powerbi.microsoft.com/ru-ru.

4. QlikView [Электронный ресурс] / URL: http://global.qlik.com/ru/landing/go-sm/qlikview/download-qlikview/

5. Tableau [Электронный ресурс] / URL: https://www.tableau.com/products/trial

6. Барсегян А. А. Технологии анализа данных: Data Mining, Visual mining, Text mining, OLAP. Учеб. пособие / А. А. Барсегян, М. С. Куприянов, В. В. Степаненко, И. И. Холод. — СПб.: «БХВ Петербург», 2014. — 383 с.

7. Варфоломеева А. О. Информационные системы предприятия. Учебное пособие / А. О. Варфоломеева, А. В. Коряковский, Романов В. П. — М.: НИЦ ИНФРА-М, 2016. — 283 с.

8. Лесковец Р. Анализ больших наборов данных: пер. с англ. Слинкин А. А. / Р. Лесковец, А. Раджараман, Дж. Ульман — М.: ДМК Пресс. — 2016. — 498 с.

9. Методы, модели, средства хранения и обработки данных: учебник / Э. Г. Дадян, Ю. А. Зеленков. — М.: Вузовский учебник: ИНФРА-М, 2017. — 168 с.

Источник: cyberleninka.ru

Платформы анализа данных: что они умеют и как понять, нужны ли они вашему бизнесу

Рынок ИТ- продуктов переполнен предложениями платформенных решений для анализа больших данных: их обсуждают, рекомендуют и внедряют, но всем ли они необходимы? Алексей Ершов, эксперт по продуктам Factory5 (входит в группу Ctrl2GO), ответил на главные вопросы об аналитических платформах для ИТ-директоров, менеджеров проектов и других участников data science инициатив на предприятиях.

Это первая обзорная статья из цикла материалов о платформах анализа данных.

Далеко не все такие инициативы успешны: глобальные исследования Gartner и других компаний показывают, что до 85% проектов не приносят бизнесу результатов. Например, аналитические модели не получается интегрировать в бизнес-процессы. Это происходит по разным причинам, в том числе техническим. Компании работают со множеством сервисов — иногда от разных производителей.

Это и инструменты business intelligence, и реляционные и NoSQL-базы данных, и инструменты для big data и data science. Возникают проблемы с интеграцией, передачей данных и их согласованной обработкой. Часть информации может просто потеряться. Эти трудности решает такой класс продуктов, как платформы для анализа больших данных, или, как еще называют, data science платформы.

Платформы анализа больших данных: что это такое и зачем они нужны

Платформа для обработки больших данных — это решение, которое объединяет различные инструменты, необходимые специалистам по data science. Такие платформы существенно упрощают их работу, охватывая весь жизненный цикл data science проектов: от идеи и исследования данных до построения и развертывания аналитических моделей. Они позволяют решить так называемую проблему «последней мили»: интегрировать результаты анализа данных в операционную деятельность, чтобы они влияли на принятие решений и трансформировали бизнес-процессы. Это может быть реализовано в виде API предиктивной модели, к которой обращаются другие системы, веб-приложения, которым могут пользоваться сотрудники, или просто ежедневного отчета, отправляемого на почту.

Объяснить, зачем нужны платформы, можно с помощью простой аналогии. Представьте, что на промышленном предприятии конструкторский отдел разработал новый продукт. Принесет ли один опытный образец пользу бизнесу? Нет — прибыль даст только серийное производство.

А для этого потребуется не только оборудование, но и регулярные поставки комплектующих, технологические карты, настроенные процессы контроля качества, обслуживания, модернизации продукта. Чтобы поставить производство на поток, нужны дополнительные ресурсы и компетенции.

Аналогичная ситуация возникает и в data science проектах. Ключевой результат работы дата сайентиста — аналитическая модель — это и есть тот самый опытный образец. Она работает, ее можно запустить, показать в действии. Но если сделать только модель, то на бизнес это не повлияет. Чтобы разрабатывать модели и превращать их из пилотных проектов в работающие бизнес-приложения, чтобы модели работали с потоками данных и не «падали», чтобы выдавали результат за разумное время, нужна соответствующая технологическая оснастка — data science платформы.

Такие решения делают работу data science специалистов прозрачной и масштабируемой. Платформы могут использовать и системные интеграторы, и конечные заказчики, у которых есть специалисты по обработке данных и аналитике.

Какие функции есть у платформ анализа больших данных

Каждый data science-проект проходит жизненный цикл, состоящий из трех этапов:

- сбор данных и исследование

- экспериментирование и разработка модели

- развертывание и интеграция.

На каждом этапе специфические задачи, которые помогает выполнять платформа. И есть более общие задачи, включающие управление данными, управление процессами обработки и масштабирования.

Для решения всех этих задач платформы обработки данных предлагают такой технический функционал: прием, подготовка и исследование данных, генерация признаков, создание, обучение, тестирование и деплой моделей, мониторинг и обслуживание системы. Также платформа должна обеспечивать безопасность данных и их хранение, каталогизацию источников, предоставлять инструменты для визуализации и формирования отчетов. Облачные платформы дополнительно дают большой объем хранилища и вычислительных мощностей.

Все перечисленные функции платформ нужны, чтобы:

- Ускорять работу специалистов.

- Публиковать модели и интегрировать их в бизнес-процессы.

- Делиться понятными, читаемыми результатами анализа с сотрудниками всех подразделений.

- Сохранять прошлые наработки, включая метаданные, код, датасеты и обсуждения, и использовать их в новых проектах.

- Создать общую базу знаний и собирать лучшие практики, на которых будут учиться новые сотрудники.

- Безопасно внедрять новые инструменты, не ломая текущие процессы и не вмешиваясь в работу коллег.

- Масштабировать вычислительные мощности.

- Контролировать доступы к каждому проекту, чтобы его видели только определенные сотрудники.

Зачем Data Science, если есть системы Business Intelligence

Иногда платформы Data Science воспринимают как аналоги систем Business Intelligence (BI), так как они тоже содержат инструменты для визуализации результатов анализа данных. Важно понимать отличия между ними, чтобы выбирать область применения.

Традиционно BI-решения используются для статических отчетов о текущем или прошлом состоянии бизнеса. Они отвечают на такие вопросы, как: «Какая динамика объема продаж в прошедшем квартале? За счет чего произошел рост или падение продаж? Какой тип продукции произвели больше всего за месяц?». Это так называемый дескриптивный или описательный анализ.

Кроме того, BI системы работают со структурированными данными, извлеченными из хранилищ данных и представляют результат анализа в виде интерактивных информационных панелей — дашбордов или отчетов.

Платформы анализа больших данных — это уже инструмент для прогностического и динамического анализа. Они позволяют делать прогнозы по развитию любой сферы бизнеса и на их основе принимать более точные решения. Типовые вопросы: «Какой оптимальный сценарий развития бизнеса? Что будет, если продолжатся текущие тренды? Что случится, если принять новое управленческое решение?».

Платформы могут использовать как структурированные, так и неструктурированные данные из множества источников, и умеют обрабатывать большие данные. Так как предиктивный анализ связан нацелен на прогнозирование какого-то параметра или события, то он фокусируется на конкретной задаче, в отличие от business intelligence. Дескриптивный же анализ должен позволять пользователям гибко создавать отчет в том разрезе, который им потребуется.

Современные BI-системы, например, Tableau или PowerBI, имеют большой набор средства визуализации: от линейных графиков и круговых диаграмм до тепловых карт и диаграмм санкей. Поэтому хотя BI-системы и data science платформы предназначены для разных задач, но они могут дополнять друг друга. Например, существующая BI-система может в удобном виде представить результаты анализа данных, которые поступают из платформы.

Платформы или open source

В некоторых компаниях специалисты по big data по-прежнему работают с open source-инструментами. Дата сайентисты чаще всего учатся на них и продолжают использовать их уже на работе. Это подтверждает исследование Normal Research и агенства New.HR при поддержке портала GeekJOB среди аналитиков, в котором респонденты чаще всего упоминают языки Python, R и соответствующие библиотеки (NumPy, Pandas и другие).

Это объяснимо, ведь у таких инструментов низкий технический порог входа: ими легко пользоваться на личном ноутбуке. Но в реальном бизнесе, когда растет и объем данных, и сложность вычислений, когда нужно обеспечить процессинг и масштабирование, объем сопутствующих работ резко увеличивается.

Эти задачи лежат уже в инженерной плоскости, а не в аналитической. Специалисты сталкиваются с необходимостью «подружить» разные решения, поделиться кодом и моделями с другими сотрудниками, а также с вопросами безопасности. На интеграцию уходит дополнительное время, а зачастую это требует и дополнительных расходов. Поддержка разных инструментов тоже закономерно требует больших усилий, чем единого решения. И даже когда open source-инструменты покрывают потребности в обработке и анализе данных, они не интегрированы с другими сервисами компании — в итоге специалистам сложно встроить ML-модели в существующее ИТ-окружение.

Современные платформы анализа больших данных не заменяют, а дополняют известные дата сайентистам open source-инструменты. Они по-прежнему могут разрабатывать модели с помощью привычных фреймворков и библиотек, а платформы предоставляют необходимый технический функционал для продуктивной работы и реализации полного цикла data science проектов. Такой подход позволяет специалистам не переучиваться и быстрее разрабатывать аналитические продукты для бизнеса.

Когда стоит внедрять платформы для анализа больших данных

Обычно в компании у каждой команды есть инструмент для упорядочивания процессов и совместной работы над задачами. Платформы обработки данных — такой же нужный инструмент для дата сайентистов, как система контроля исходного кода для разработчиков, CRM для отдела продаж и helpdesk для технической поддержки.

Например, в небольших компаниях вместо CRM используются excel файлы или облачные kanban сервисы. Разные менеджеры могут использовать разные инструменты. На определенном этапе возникают проблемы: информация не хранится в одном месте, нет единого доступа к ней у руководителей, файлы увеличиваются в объеме, в них долго искать информацию и трудно масштабировать такую систему. Схожие трудности возникают и в data science проектах. Вот признаки того, что вам пора начать использовать платформу анализа больших данных:

Если вы замечаете, что инструментов становится слишком много, вы тратите много времени на рутинные задачи, а время на обработку данных и обслуживание разных инструментов только растет — вероятнее всего, вам пора переходить на DS-платформу.

Когда вам необходимо тиражировать разработанное приложение на другие направления бизнеса, или один из этапов обработки данных потребовал больше вычислительных ресурсов, то возникает потребность в масштабировании. Если вам нужно масштабироваться, но вы не очень хорошо представляете, как именно это сделать, то платформа просто необходима.

Если в команде дата сайентистов начинаются проблемы с коммуникацией, то это говорит об отсутствии централизованных знаний, которыми можно легко делиться между собой. Современные платформы предоставляют доступ разным сотрудникам, вовлеченным в проект.

Рынок data science платформ растет вместе с рынком искусственного интеллекта и углубленной аналитики данных. По оценкам агентства Markets and Markets, рынок платформ для анализа больших данных растет в среднем на 30% в год. Появляются новые продукты, которые разработчики называют «платформами для анализа данных» или “data science platform”, и неподготовленному человеку может быть сложно в них разобраться.

- платформенные решения

- анализ данных

- data science

- Блог компании Factory5

- Big Data

Источник: habr.com

Платформы обработки данных: какие бывают и всем ли нужны

Рассказываем, в какой момент бизнесу стоит организовать платформу для обработки данных и какие варианты есть в России.

Эта инструкция — часть курса «Выстраиваем работу с ML».

Смотреть весь курс

Обрабатывают данные, то есть вытаскивают из них пользу, совершенно разнопрофильные компании. Даже сеть семейных парикмахерских на районе может вести отчеты в Excel, используя ее как CRM-систему. На основе данных вывели список клиентов, давно не приходивших на стрижку? Самое время кинуть им sms с «индивидуальной» скидкой.

В какой момент бизнесу стоит организовать целую платформу для обработки данных? Всегда ли обработка данных — это про big data? И какие варианты есть сейчас в России? Рассказываем в тексте.

От Excel до ML — уровни зрелости дата-аналитики

В начале текста мы упомянули семейную парикмахерскую. Хороший пример, чтобы продолжать рассказывать про то, что вообще происходит в мире аналитики данных. Для дальнейшего повествования пусть это будет сеть барбершопов «Бородатый сисадмин».

Ниже — график зрелости аналитических систем, основанный на классификации компании Gartner. На нем можно выделить четыре уровня. Далеко не каждая компания линейно проходит эволюцию от начала до конца. Есть те, что «с ноги» врываются на 3-4 уровни. Главное, чтобы были необходимые ресурсы — деньги и специалисты, а также соответствующие бизнес-задачи.

А есть компании, которые за все время существования так и останутся на Excel-таблицах и простенькой BI-системе. Это тоже нормально.

Наш «Бородатый сисадмин» пройдет по каждому этапу, чтобы было проще понять разницу уровней зрелости.

Первый уровень: описательный

Первые три пункта объединим в один блок: сырые и очищенные данные, стандартные отчеты. Это самый низкий уровень работы с данными, который чаще всего производится в Google Таблицах или Excel.

Так, наш барбершоп начал собирать данные о клиентах, которые приходят на стрижку, и считать посещения. Администратор вбивает информацию вручную, некоторые данные стягиваются из формы регистрации на сайте. Менеджер может очистить данные от дублей, поправить ошибки, которые были совершены при регистрации, и даже структурировать данные по количеству и разнообразию оказанных услуг в месяц.

На основе этого можно делать обычные отчеты. Узнать, растет ли количество клиентов месяц к месяцу, что дало больше дохода за лето — стрижка бороды и волос.

Эти данные отвечают на вопрос: что случилось? На основе них можно формулировать гипотезы и принимать решения. В большинстве своем — в ручном режиме и за счет когнитивных усилий менеджера.

К этому же уровню относятся такие форматы аналитики, как Ad hoc reports и OLAP. Ad hoc reports — это отчеты, сделанные под конкретный бизнес-запрос. Чаще всего это что-то нестандартное, чего нет в обычной отчетности. Например, перед менеджером «Бородатого сисадмина» стоит задача узнать, сколько продаж случилось за три месяца для когорты лысых, но бородатых посетителей (с разбивкой по дням).

Второй уровень: диагностический

На этом уровне — так называемая аналитика самообслуживания (self-service BI). Она подразумевает, что выполнять запросы к нужным данным и генерировать обобщающие отчеты могут специалисты разных профилей, а не только аналитики данных. Такой подход также проявляется в использовании BI-cистем типа Power BI, Qlik или Tableau. При этом дашборды в них, как правило, настраивают специалисты по работе с данными.

Здесь данные отвечают на вопрос, почему это случилось? Они не просто описывают нынешнее состояние компании, но являются источником аналитических выводов. Например, выручка «Бородатого сисадмина» выросла в 2 раза в сравнении с предыдущим месяцем. Данные показывают, что случилось это из-за нескольких рекламных постов в Telegram об акции барбершопа.

На этом уровне компания может перейти от Excel-таблиц к Python-скриптам и SQL-запросам. Также здесь уже не обойтись без одного-двух дата-аналитиков в команде.

Зачем вообще переходить на более сложные инструменты?

Причины могут отличаться для каждой конкретной компании:

- Увеличился объем работы с данными. Компания стала не только подсчитывать прибыль и расходы за месяц, но и собирать данные по маркетинговым активностям, фиксировать отток клиентов и так далее. Плодить десятки новых Excel-таблиц становится нерационально — в них легко запутаться и сложно проводить корреляции между событиями.

- Появилась потребность в автоматизации. Сотрудники тратят много времени, чтобы собирать данные вручную. Это время они могут посвятить более полезной для роста бизнеса работе.

- Нужно повысить качество данных. Чем меньше автоматизации процессов, тем больше поле для человеческих ошибок. Какие-то данные могут перестать собирать или вносить с ошибками. Автоматизация и BI-системы помогут лучше «чистить» данные и находить новые направления для аналитики.

- Увеличилось число аналитиков. Например, компания стала развиваться в нескольких регионах. В каждом — свой аналитик, но сводить данные им нужно в одном месте. Для унификации инструментов и подходов можно использовать единую BI-систему и общее хранилище (или хотя бы базу данных).

Третий уровень: предикативный и предписательный

На этом уровне начинается работа с более сложными концептами. Речь о предсказательной и предписательной аналитике.

В первом случае данные отвечают на вопрос, что будет дальше. Например, можно спрогнозировать рост выручки или клиентской базы через полгода. Тут алгоритм анализа может лечь в основу ML-модели.

Предписательная аналитика строится на вопросе, что стоит оптимизировать. Данные показывают: чтобы показатели выручки барбершопа выросли на 60%, нужно увеличить бюджет на рекламное продвижение на 15%.

На этом этапе речь уже не о нескольких аналитиках, а о целой команде, которая может работать на несколько бизнес-направлений. Как правило, в этой точке у компаний появляется необходимость в платформах для обработки данных.

Четвертый уровень

«Вышка» — это автономные системы аналитики на основе искусственного интеллекта. Тут машина предлагает некоторое предположительно верное решение по результату анализа больших данных, а человек принимает финальное решение.

Подобные системы могут использовать банки. Например, это могут быть скоринговые системы для выдачи кредитов. А наш барбершоп может использовать Lead scoring — технологию оценки базы данных клиентов с точки зрения их готовности приобрести продукты компании.

Третий и четвертый уровни только для больших данных?

Короткий ответ — нет.

Объем данных не так важен, как задачи, которые стоят перед компанией

Конечно, чем больше данных, тем репрезентативнее результаты. Но оперировать доводами в духе «у меня база всего на миллион человек, вся эта платформенная обработка — не для меня» тоже неверно.

Данных может быть немного, но они могут быть очень разнообразными: записи бесед с клиентами, записи с камер наблюдения, пользовательские изображения и т.д. Все это нужно систематизировано хранить, чтобы успешно извлекать из них ценные для компании, применимые в бизнес-задачах знания.

Объем данных не так важен, как количество аналитики и аналитических команд

Если в компании несколько аналитических команд по разным бизнес-направлениям, это приводит к проблемам. Команды могут использовать один источник данных, но при этом разные инструменты аналитики, разные хранилища. Иногда они могут анализировать одно и то же или по-разному считать один и тот же показатель, что не очень рационально. Если добавить новую аналитическую команду, она рискует начать дублировать часть уже сделанной работы.

Разнородность аналитических пайплайнов также приводит к задержкам в выполнении требований бизнеса. Продакт-менеджер попросит починить дашборд с выручкой по продукту, а фикс получит только через 1,5 месяца.

Когда растут сложность аналитических задач и число аналитиков, компании задумываются о платформах обработки данных. Они дают общую базу, общепринятые договоренности: с помощью каких инструментов и как мы забираем данные из источников, куда их складываем, каким образом организуем хранилище.

Из чего состоят платформы обработки данных

В целом, дата-платформа — это набор интегрированных между собой инструментов, которые позволяют компаниям делать регулярную и воспроизводимую аналитику данных.

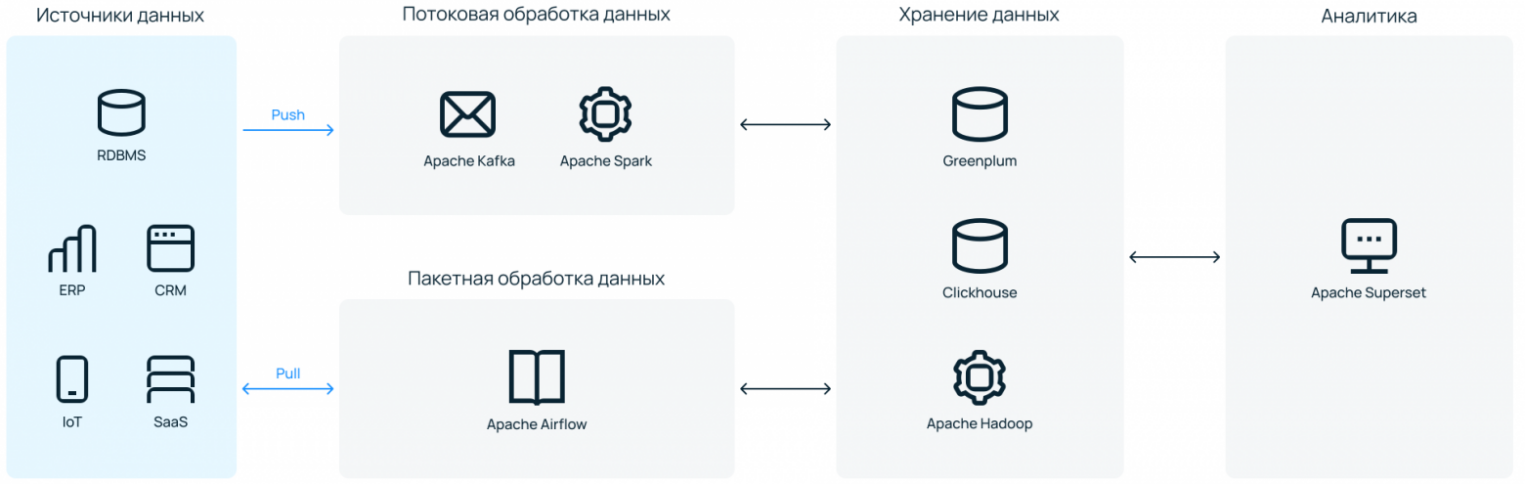

Набор инструментов может быть разнообразным, но вкладываются они примерно в один и тот же пайплайн работы с данными:

- Источники. Весь набор источников данных — от простых файлов и реляционных БД до SaaS-решений, собирающих какую-либо потенциально полезную для бизнеса информацию.

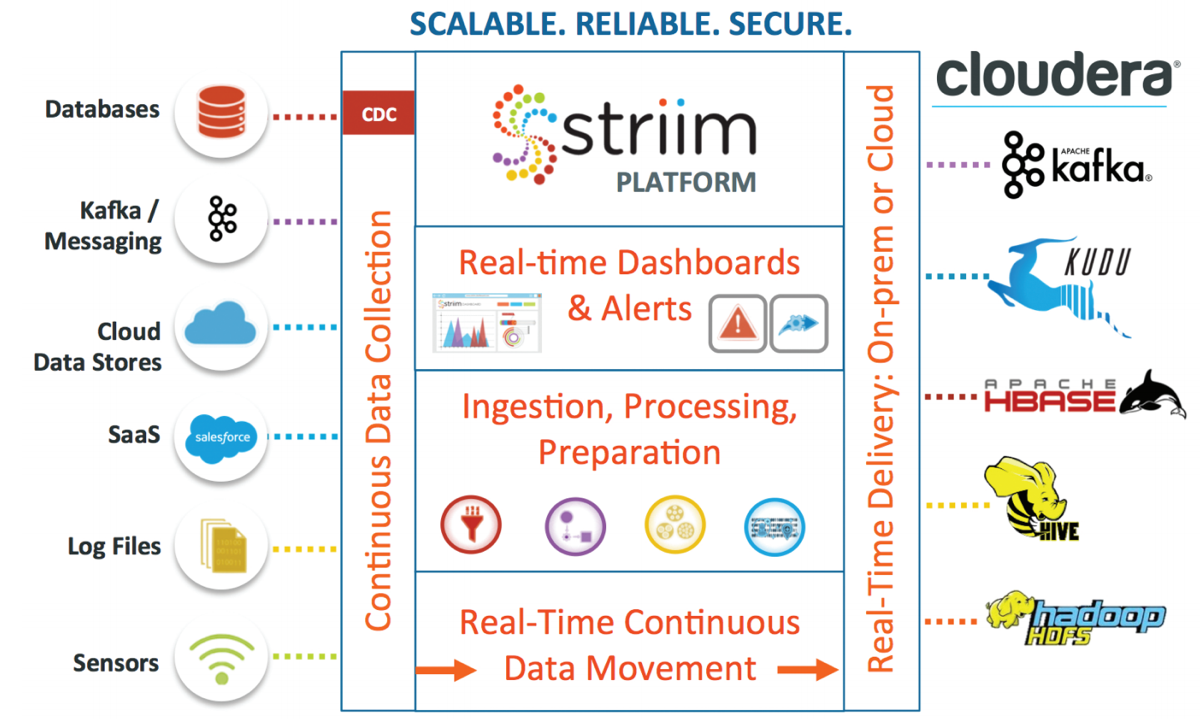

- Обработка и трансформация данных. Здесь в работу вступают ETL- или ELT-инструменты. Данные забираются из источника, подвергаются преобразованиям, если это необходимо, и направляются в хранилище. Здесь могут быть задействованы такие инструменты, как Apache Spark, Kafka, Airflow.

- Хранение данных в формате, подходящем для дальнейшей работы c ними. Самыми популярными тулзами для этого являются Greenplum, Clickhouse, Vertica, инструменты из экосистемы Hadoop.

- Непосредственно анализ данных — описательный и/или предсказательный. В качестве инструмента тут может использоваться SQL, Python или любые другие языки.

- Вывод/визуализация данных для конечных пользователей. Чаще всего какая-то принятая в компании BI-система (Power BI, Qlik, Tableau, Apache Superset или их аналоги).

Это грубое деление на этапы работы, которые охватывает платформа для обработки данных. Архитектура конкретного решения может быть более сложной. Один инструмент может охватывать несколько этапов работы, а какой-то определенный этап, например, хранение или трансформация данных, может быть более комплексным.

Как построить дата-платформу

Здесь вернемся к нашему «Бородатому сисадмину». Довольно сложно представить барбершоп, которому нужна платформа обработки данных, но мы уже слишком далеко зашли. Представим, что им управляет Федор Овчинников. Филиалы барбершопа открыты в 4 регионах страны и 22 городах. А еще он запустил онлайн-курсы по уходу за бородой в домашних условиях и всероссийскую платформу для барберов с системой личных кабинетов.

В общем, данных много, запросов для роста бизнеса тоже, аналитические команды не справляются. Какие есть варианты?

Создаем самостоятельно, с нуля

Самый трудно реализуемый вариант, но исключать его полностью нельзя. В таком случае компании нужно нанимать дорогостоящих на рынке специалистов — DevOps- или дата-инженеров. И надеяться, что они справятся без дата-архитектора (или нанять и его тоже).

Также нужно будет арендовать или закупать инфраструктуру под платформу. Понадобятся быстрые серверы и хорошие пропускные каналы. Если инфраструктура on-premises, серверы, естественно, нужно будет еще обслуживать (+ сменные инженеры в техническую команду для обслуживания 24/7).

Весь набор выбранного для платформы ПО нужно будет настроить и «подружить» между собой, чтобы обработка данных проходила максимально автономно и без сбоев. Отраслевого стандарта по факту нет, готовых инструкций очень мало.

В общем, проект масштабный — нужно вложить большие средства в то, что не будет приносить прибыли до и немного после окончания «стройки». А работа может растянуться в лучшем случае на несколько месяцев.

Нашему барбершопу не подходит. Нужных специалистов нет, IT-бренда, чтобы привлекать хороших специалистов, нет, а профит от анализа данных нужен как можно быстрее.

Нужно искать что-то более готовое. Какие есть варианты?

Идем к облачному провайдеру

У зарубежных компаний, которые нередко cloud native, есть один распространенный сценарий. Когда нужна платформа для обработки данных, они идут к одному из популярных иностранных облаков — например, AWS, Google Cloud, Azure — и там из отдельных «кубиков» собирают себе систему.

У них много продуктов, и там можно найти нужное «коробочное» решение для каждого из этапов пайплайна, который мы рассмотрели выше. «Кубики», впрочем, тоже нужно будет связать — с помощью собственных cloud-архитекторов или соответствующего managed-сервиса от провайдера.

Приобретаем готовую платформу

Еще один вариант — обратиться, например, к компании Cloudera, которая на данный момент является единственным адекватным поставщиком Hadoop. У них можно получить готовую, уже собранную платформу и даже техническое сопровождение. Но будет дорого. Ценник сможет принять только крепко стоящий на ногах энтерпрайз.

Где проблема? Владелец «Бородатого сисадмина» понимает, что оплата сервисов сейчас затруднена, платить нужно в долларах, а данные безопаснее хранить на территории России. Нужно рассматривать отечественные альтернативы.

Что в России?

В стране есть альтернативы обоим «западным» форматам: и набор необходимых PaaS-решений в облаке, не связанных между собой, и варианты, что ближе к «коробочным». В этом тексте не будет подробного обзора российских решений — этому стоит посвятить отдельный текст (кстати, напишите в комментариях, если вам будет интересно почитать такой обзор).

Здесь мы сосредоточимся на варианте, который обособлен от существующих решений и может быть полезен тем, кто ищет баланс между ценой и качеством.

Арендуем инфраструктуру с предустановленным ПО для обработки данных

Наша ситуация: у «Бородатого сисадмина» нет компетентных архитекторов и нескольких миллионов на интеграцию «коробочного» решения. Какие есть еще варианты?

У Selectel появилась платформа обработки данных — сервис, который снимает с бизнеса сразу две боли: необходимость связывать сервисы в одной инсталляции и заниматься вопросами безотказной работы инфраструктуры.

Работает как ателье. Клиент — это может быть CTO, DevOps, главный аналитик, дата-инженер — рассказывает о своих потребностях. Указывает «мерки»: сколько данных обрабатывается, какой вид обработки нужен — потоковая или пакетная (можно обе), что хочется получать на выходе.

Под требования подбирается инфраструктура — выделенные серверы на высокочастотных процессорах (до 3,6 ГГц) с большим объемом RAM и быстрыми дисками. На ней дата-инженеры из ITSumma поднимают все необходимое ПО под платформу обработки данных — настраивают сетевую связность и все необходимые каналы их взаимодействия.

Минимально достаточное число серверов — четыре машины. Это необходимо для обеспечения отказоустойчивости. Большинство из систем, устанавливаемых в платформу, — распределенные, нужно несколько мастер-нод, размещенных на разных «железных» хостах. Верхняя граница не устанавливается. Инфраструктура под платформу может масштабироваться горизонтально под запросы клиента.

Выбранное ПО — инструменты, которые можно встретить в большинстве эволюционно зрелых дата-платформах. Это open source, поэтому можно не переживать из-за вендор-лока.

Другие особенности

Умеренная кастомизируемость. Клиент может подключать любой источник данных, который ему удобен. Также можно синхронизировать вывод данных в BI-систему клиента, если он, например, использует не Apache Superset. В остальном стек негибкий: поменять один инструмент на другой или добавить инструмент к существующему списку не получится.

Можно удалить лишние элементы — например, Kafka и Spark, если компания не занимается потоковой обработкой данных. Это позволит снизить нагрузку на инфраструктуру и сэкономить место для хранения данных.

Контроль на каждом этапе. Клиент получает доступ ко всему: от физической инфраструктуры до интерфейсов каждого из входящего в нее инструмента. Всегда можно добавить новый источник данных или запланировать выполнение нового Python-скрипта в Airflow. Это можно сделать также через поддержку в ITSumma. Если компании это не надо, такой вариант тоже рабочий.

И инфраструктура, и софт будут настроены для работы с данными без участия ее сотрудников.

Отдельный бонус — можно добавить к платформе сопровождение дата-инженеров ITSumma, исключив необходимость нанимать in-house специалистов. Все через панель управления Selectel.

Платформа обработки данных Selectel

Инфраструктура для хранения и обработки больших данных, сделанная по вашим меркам.

Не обязательно быть клиентом. Чтобы построить платформу обработки данных в Selectel, не обязательно хостится на инфраструктуре компании. Сетевую связность можно настроить как on-prem-площадки. Единственное — при этом сценарии могут быть ожидаемые задержки при трансфере данных из источников. Для высоконагруженных систем и систем, чувствительных к latency, лучше перевезти обрабатываемые данные ближе к месту размещения платформы.

Стоимость платформы складывается из стоимости инфраструктуры и работы дата-инженеров ITSumma. Оплата помесячная. Время построения платформы зависит от сложности запроса конкретной компании. На выходе клиент получает отказоустойчивую, хорошо отлаженную систему для регулярной обработки данных.

Зачем компаниям платформы обработки данных

Мы уже много написали о структуре и вариантах реализации дата-платформ. Теперь коротко о том, почему компаниям может быть полезно использование платформ для обработки данных:

- На подготовленных качественных данных можно строить рекомендательные системы (актуально для e-commerce и ритейла). Именно они после заказа продуктов в сервисе доставки предлагают ваши любимые продукты со скидкой. Так компания повышает средний чек и занимается допродажей услуг.

- Компания получает общий инструментарий для всех аналитических команд в компании: ограничивает список используемых инструментов и экономит на найме новых специалистов.

- Платформы данных помогает поднять аналитику на новый уровень — от описательной к предсказательной — и получать более ценную для бизнеса информацию.

- В решениях с технической поддержкой можно перевести траты на работу дата-инженеров из ФОТ в OPEX.

- Готовые платформы снизят нагрузку на дата-инженеров и дата-сайентистов. Они не будут тратить время на настройку софта и его совместимости с инфраструктурой.

Платформы обработки данных — не мастхэв для каждой компании, но и не какой-то уникальный инструмент, который доступен только большим и очень большим компаниям. Это может быть решение и для среднего бизнеса, который хочет расти и видит этот рост именно в data-driven подходе.

Каким должен быть Feature Store, чтобы оптимизировать работу с ML-моделями

Источник: selectel.ru